Röntgen-Computertomographie (CT) und Laminographie sind einzigartige Werkzeuge für die systematische Untersuchung von opaken Materialien und biologischen Proben. Über die spezifische Absorption der durchstrahlten Materialien können innere Strukturen des abgebildeten Objekts beobachtet werden. Bei herkömmlichen CT-Systemen wird das Objekt auf einem rotierenden Probentisch zwischen dem Röntgenstrahl und einem Detektor platziert, der ein zweidimensionales Intensitätsbild der einfallenden Röntgenstrahlen aufnimmt. Bei einer 360°-Drehung des Objekt zwischen Quelle und Detektor werden Röntgenbilder in typischerweise äquidistanten Drehwinkeln aufgenommen. Ein tomographischer Rekonstruktionsalgorithmus wird dann auf die Seuqenz der erfassten Röntgenbilder angewendet, um ein volumetrisches Röntgenbild des Objekts zu berechnen. Dies Bild besteht aus einer dreidimensionalen Anordnung von Volumenelementen (Voxeln). Jedem Voxel ist ein Grauwert zugeordnet, der der Röntgenstrahlenabschwächung im repräsentierten Volumenelement entspricht. Die Laminographie ist eine spezielle Art der Röntgentomographie, die für flache Proben verwendet wird. Bei einer flachen Probe, wie z.B. einer Leiterplatte oder einem historischen Ölgemälde, steigt bei der CT die Röntgenabsorption in der Probe drastisch an, wenn die lange Kante der Probe nahezu parallel zur Richtung der Röntgenstrahlen liegt. In solchen Fällen ist es vorteilhaft, die Probe zu kippen, so dass die Objektebene nicht parallel zum einfallenden Strahl ist. Die Probe wird dann um einen gegenüber der Flächenormale des Objektes leicht gekippten Vektor gedreht.

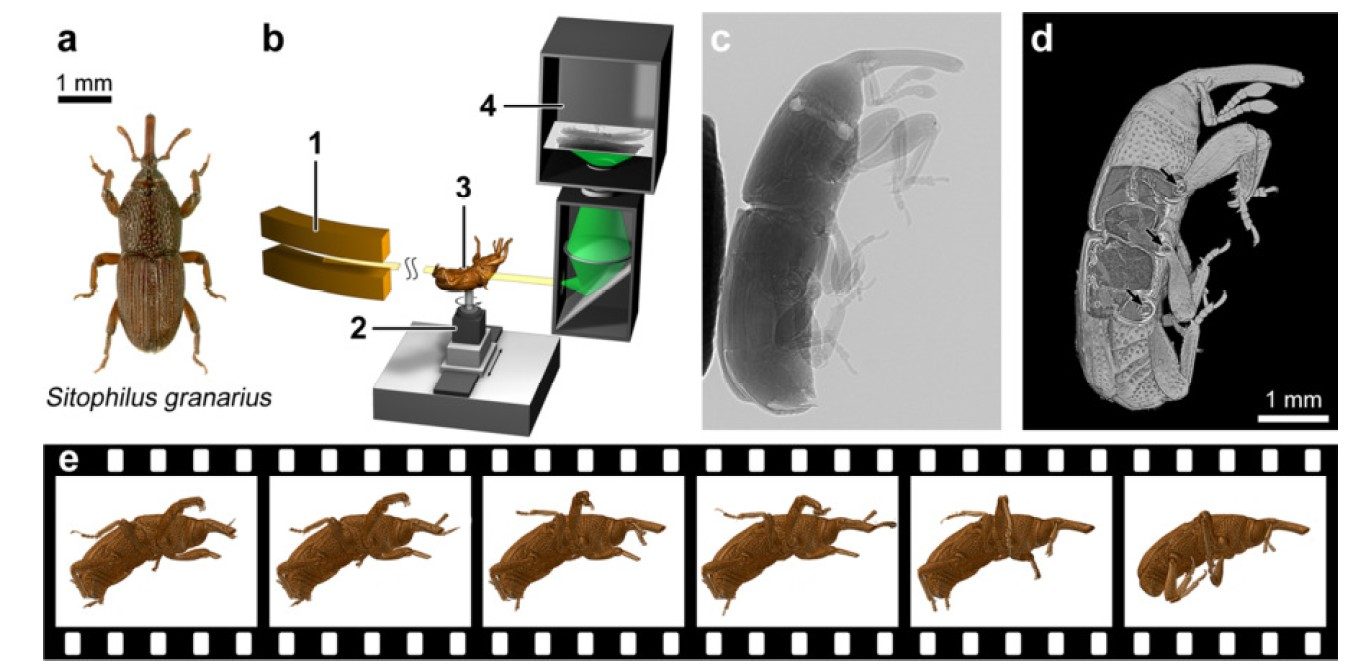

Synchrotronanlagen bieten inzwischen eine Flussdichte des Röntgenstrahles an, die in Kombination mit schnellen Bildsensoren die Aufnahme von Tomogrammen in weniger als einer Sekunde erlauben. Kombiniert mit der Korrektur von Bewegungsartefakten hat dies neue Ansätze für 4D (Raum+Zeit) in situ, operando und sogar in vivo-Studien ermöglicht. Mit diesen Methoden lassen sich z.B. die Strukturentwicklung von Materialien, technologische Prozesse oder biologischen Vorgänge in Zellen oder Geweben und Bewegungsabläufe von kleine Organismen beobachten.

Aufgrund der Komplexität des Versuchsaufbaus sind die Automatisierung und die Versuchsplanung eine Herausforderung. Für einen erfolgreichen automatisierten Scan müssen der Abbildungs- und Probenapparat richtig ausgerichtet und positioniert, die Probe stabilisiert und der Messaufbau während des gesamten Abbildungsprozesses kontrolliert werden. Darüber hinaus ist eine intelligente Steuerung des Bildgebungsprozesses mit einer dynamischen Anpassung der Region of Interest (ROI) besonders schwierig, da sie zusätzlich Online-Informationen über den untersuchten Prozess erfordert. Bei falscher oder zu später Berechnung der Prädiktion kann die ROI vollständig verfehlt werden. Dieses Problem tritt besonders dann auf, wenn die Position der Probe im 4D-Raum nicht a priori bekannt ist oder sich während des Scans ändert. Obwohl zweidimensionale (2D) Röntgenaufnahmen bereits oft gute Informationen für ein schnelles Online-Feedback für vielen Anwendungen enthalten, ist es wünschenswert in bestimmten Fällen Qualitätsmetriken aus der 3D- oder gar 4D-Bildrekonstruktion abzuleiten.

Darüber hinaus ist die zeitliche Abtastung und Dauer von in-vivo-Experimenten, also mit lebenden Objekten derzeit durch Strahlenschäden begrenzt. Die Strahlendosis kann reduziert werden, indem weniger Projektionen zur Rekonstruktion eines einzelnen Tomogramms verwendet werden oder indem die Belichtungszeit für jede Projektion reduziert wird. Bei traditionellen Rekonstruktionstechniken führen beide Ansätze zu Artefakten in der 3D-Darstellung. Auch die Bewegung der Objekte während des Experiments beeinflusst die Rekonstruktionsqualität. Die „Compressed sensing“-Theorie erlaubt die Rekonstruktion von Signalen aus unterabgetasteten Daten. Unvollständige Messungen können so kompensiert werden, und die Bilder lassen sich mit Hilfe eines nichtlinearen Optimierungsschemas auch bei einer geringeren Anzahl von Messungen rekonstruieren. Solche Optimierungstechniken sind jedoch sehr rechenintensiv.

In Zusammenarbeit mit dem KIT-Imaging-Cluster entwickeln wir die nächste Generation von Experiment-Kontrollsystemen, um eine schnelle Datenauswertung in die Datenerfassung einzubinden und so die Verfolgung schneller Prozesse mit hoher räumlicher und zeitlicher Auflösung zu ermöglichen. Das entwickelte Kontrollsystem wird derzeit an zwei Experimentierstationen des KIT-Imaging-Clusters eingesetzt. Während wir uns auf Synchrotron-Tomographie und Laminographie konzentrieren, können unsere Technologien leicht an verschiedene Arten von Detektoren übertragen werden. Die aktuell maximal in Echtzeit verarbeitete Datenrate beträgt etwa 8 GB/s und steht für Online-Überwachung, und Steuerung zur Verfügung. Die Software-Plattform ist Open Source und alle Software-Komponenten sind frei verfügbar unter https://github.com/ufo-kit .

Unsere UFO-Plattform (Ultra-Fast tOmography) deckt die gesamte Prozesskette vom Röntgendetektor bis zur Archivierung der Daten ab. Das System umfasst Hardware- und Softwarekomponenten und schlägt eine Entwurfsrichtlinie für die Recheninfrastruktur vor. Primäre Designziele waren ein geringer Verwaltungsaufwand, kosteneffiziente Standardkomponenten und die Möglichkeit, die Ausrüstung in der Synchrotronanlage zu verteilen. Wichtige Komponenten des Frameworks sind Vernetzung, Treiber für wissenschaftliche Kameras, Rechnerinfrastruktur und Kontrollsystem.

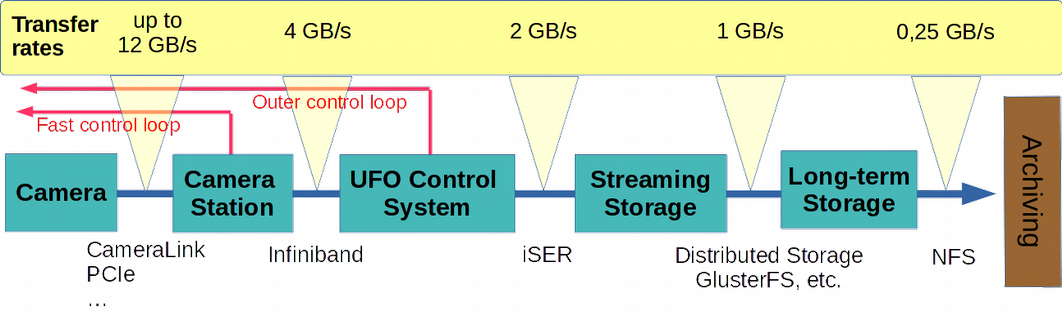

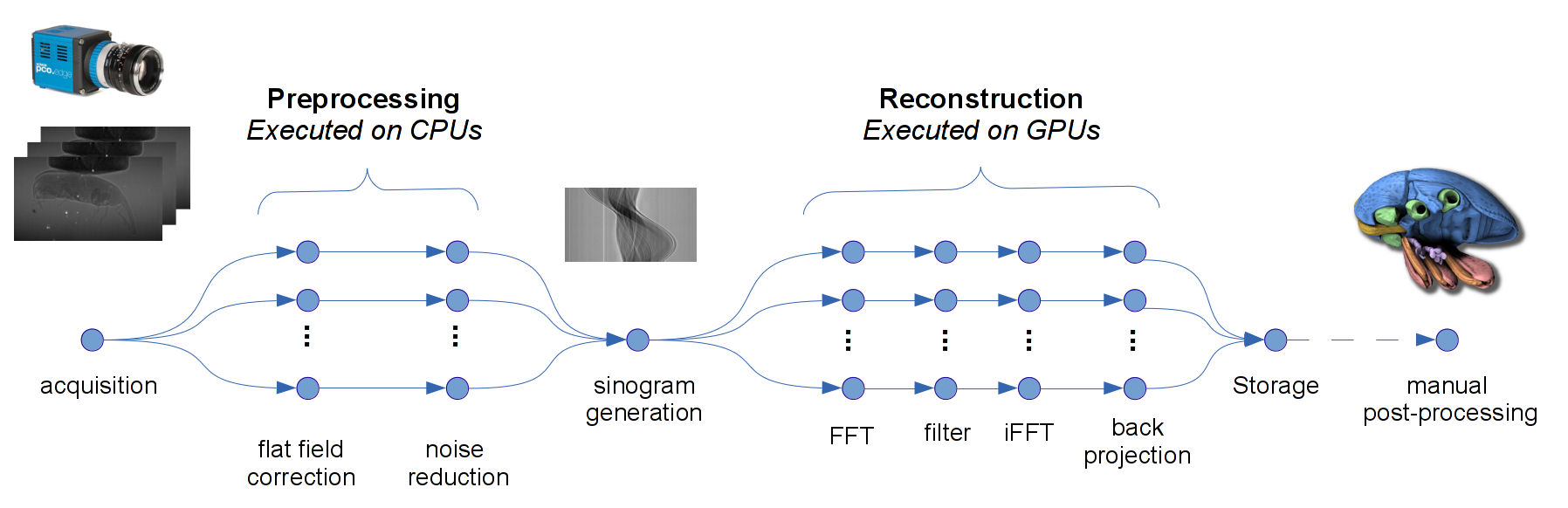

Der Datenfluss ist wie in Abb. 2 skizziert organisiert. Zunächst werden die Daten mit einer einzigen GPU direkt an der Kamerastation vorverarbeitet. In dieser Phase wird die mögliche Rückkopplung auf der Basis von 2D-Projektionen an die Beamline-Instrumentierung zurückgegeben. Nach der Online-Datenreduktion werden die Bilddaten dann an das verteilte UFO-Kontrollsystem zur 3D-Rekonstruktion und Datenanalyse weitergeleitet. Hier werden Informationen für eine zweite Rückkopplungsschleife auf der Grundlage der rekonstruierten 3D-Bilder extrahiert. Weiter werden die Rohdaten an den Hochgeschwindigkeits-Streaming-Speicher übertragen .

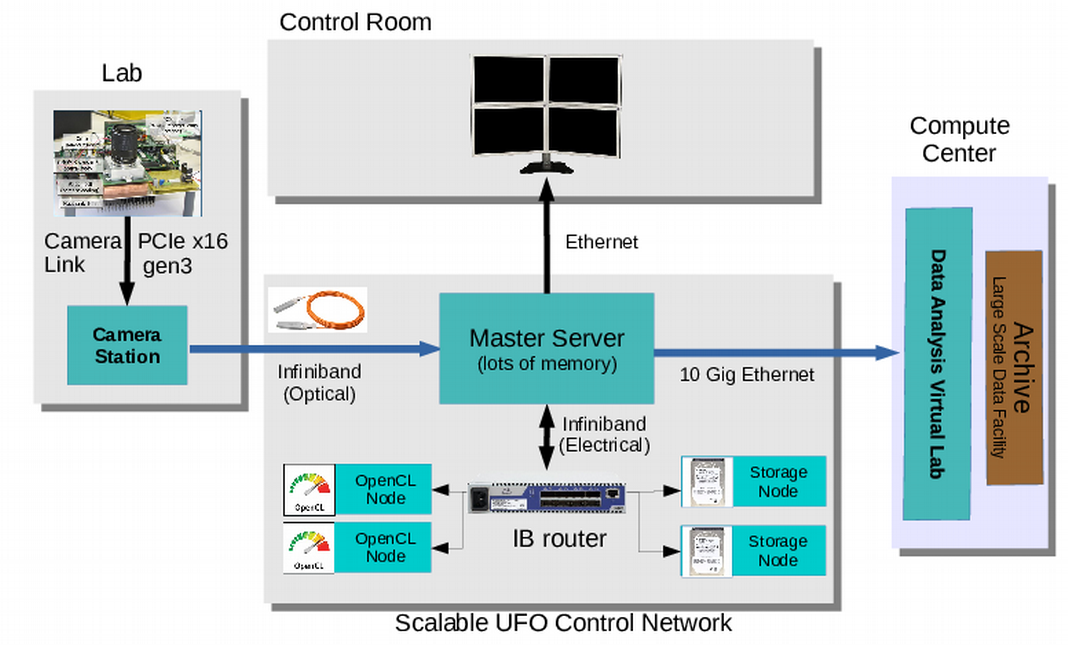

Zum Aufbau des DAQ-Netzwerks verwenden wir vier verschiedene Arten von Knoten: Kamerastation, Master-Server, Rechenknoten und Speicherknoten. Die Architektur ist in Abb. 3 skizziert. Ein Infiniband-Netzwerk verbindet die Systemkomponenten. Die Kamerastation ist Teil der Experimentierstation, während die anderen Komponenten sich außerhalb befinden und über eine optische Infiniband-Verbindung mit der Kamerastation verbunden sind.

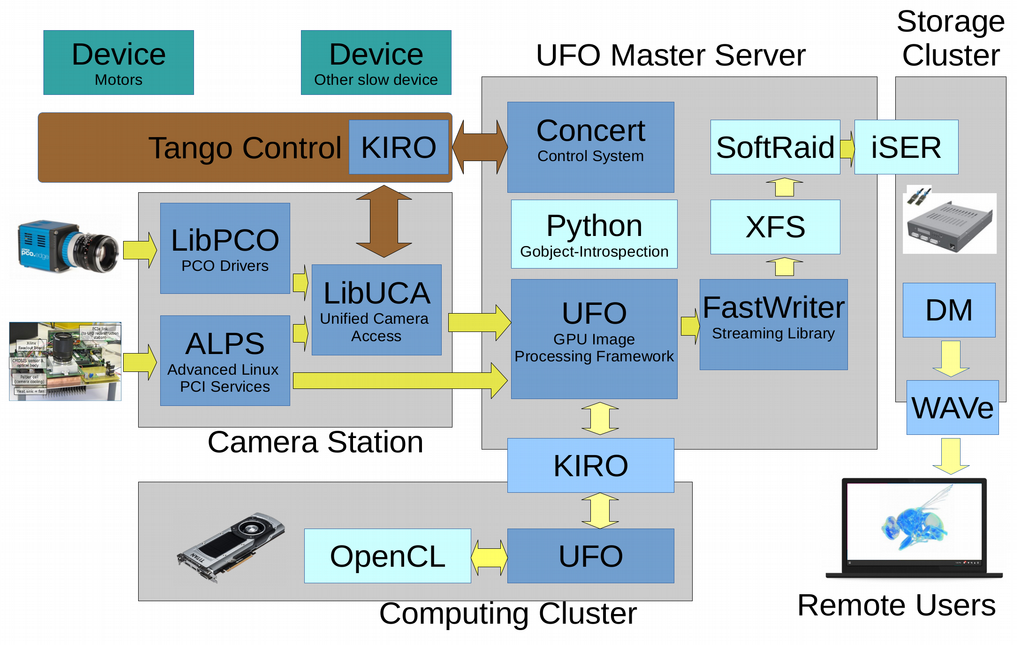

Mehrere Softwarekomponenten wurden entwickelt, um die Anforderungen des UFO-Kontrollsystems zu erfüllen. Einen Überblick über die zur Realisierung der im UFO-Kontrollsystem verwendeten Softwarekomponenten gibt Abb. 4. Das zentrale Element des Systems ist das parallele UFO-Bildverarbeitungs-Framework. Das Steuerungssystem „Concert“ ermöglicht den Aufbau bildbasierter Regelkreise durch die Integration des UFO-Frameworks und der Beamline-Instrumentierung. Die Schnittstelle zu den Kameras wird durch die „Unified Camera Access Library“ (libuca) bereitgestellt. Neben kommerziellen Kameras sind eine Reihe von am IPE entwickelten programmierbaren Streaming-Kameras eingebunden. Um die Vorteile der hohen Datenübertragungsraten des Infiniband-Netzwerks voll auszuschöpfen, wurde die „KIT Infiniband Remote Communication-Bibliothek“ KIRO entwickelt. Sie unterstützt das native Infiniband-RDMA-Protokoll. Die Bibliothek kann Datenübertragungsraten von bis zu 4,7 GB/s und Latenzen in der Größenordnung von 20 us für den Infiniband FDR-Standard erreichen.

Die Messergebnisse werden während des Experiments zunächst mit dem FastWriter-Modul auf die Hochgeschwindigkeitspartition des UFO-Echtzeitspeichers gestreamt und später, nach Abschluss des Experimentes, in der „Large Scale Data Facility (LSDF)“ des KIT archiviert. Um eine schnelle Vorschau auf die archivierten 3D-Datensätze zu ermöglichen, wurde die Webanwendung Web Analysis of Volumes (WAVe) entwickelt. Viele neuere mobile Geräte sind mit leistungsfähigen GPU-Adaptern ausgestattet und können die von WAVe angebotene Visualisierung der 3D-Volumen anzeigen.

UFO-Bildverarbeitungs-Framework

Das zentrale Element des Systems ist das Bildverarbeitungs-Framework UFO. Der Bildverarbeitungs-Workflow wird durch einen strukturierten Graphen konfiguriert, wobei jeder Knoten einen Operator darstellt. Das UFO-Framework enthält per Design mehrere Parallelitätsebenen: feinkörnige massive Parallelität, Pipelining und die gleichzeitige Ausführung von Verzweigungen innerhalb des Graphen. Die Bildverarbeitungsalgorithmen in der Bibliothek sind in OpenCL implementiert und sorgfältig für aktuelle GPU-Architekturen von AMD und NVIDIA optimiert.

Der UFO-Scheduler ist so programmiert, dass er Multi-GPU- und Cluster-Setups ermöglicht. Die Basis für den Scheduler ist ein Graph der Prozessierungsschritte und die Beschreibung der verfügbaren Hardware, wie Anzahl von GPUs, CPUs und Remote-Computerknoten und wie auf sie zugegriffen werden kann. Der Scheduler versucht, die beste Lösung der Aufgaben für die verfügbare Hardware zu finden. In den meisten Fällen wird die Hardware jedoch nicht vollständig genutzt, da in der Regel weit mehr Recheneinheiten als Rechenschritte vorhanden sind. Um dieser Situation Rechnung zu tragen, erweitert der Scheduler den Aufgabengraphen, indem er die Struktur des Graphen untersucht. Jede Sequenz, die potenziell auf GPUs ausgeführt werden können, wird dupliziert und in die graphische Darstellung des Workflows eingefügt. Zur Ausführungszeit werden dann diese Sequenzen einer GPU zugeordnet, um Speichertransfers zwischen den GPUs zu vermeinden.

Dieselbe Idee wird zur Unterstützung des Clustering verwendet: Sequenzen langlaufender Berechnungen werden identifiziert, gekapselt und die Beschreibung an den Remote-Knoten gesendet. Im ursprünglichen Graphen sendet ein Datenaustauschknoten Daten an den eingebundenen Rechenknoten und empfängt die resultierenden Daten von dort, wodurch die Daten wieder in den ursprünglichen Graphen eingefügt werden. An jedem Berechnungsknoten wird ein UFO-Dämon gestartet, der auf Anfragen vom Master-Prozess wartet. Wenn das UFO-Framework Daten zur Verarbeitung an einen Dämon übertragen möchte, sendet es eine Anforderung an den Dämon und bittet ihn, einen leeren Puffer mit ausreichender Größe für die Speicherung der zu sendenden Daten vorzubereiten. Sobald der Dämon diese Anfrage bestätigt hat, werden die tatsächlichen Daten, die sich im Puffer befinden, gesammelt und an den Dämon gesendet, der sie in dem neu erstellten, leeren Puffer ablegt. Von diesem Zeitpunkt an geht die Berechnung auf dem Dämon auf die gleiche Weise weiter wie in einer normalen, lokalen UFO-Kette. Und nachdem die Berechnungen abgeschlossen sind, geschieht dasselbe noch einmal, nur in der entgegengesetzten Richtung.

Steuerungssystem "Concert”

Das High-Level-Steuerungssystem "Concert" dient zur Steuerung der Beamline-Instrumentierung und zur Kontrolle des Experimentverlaufs. Es basiert auf dem UFO-Framework und soll bildbasierte Regelkreise durch die Integration von Echtzeit-Datenverarbeitung und Beamline-Instrumentierung ermöglichen. Die Regelkreise werden durch einfach zu schreibende Python-Skripte unter Verwendung von Komponenten, die von "Concert" und dem UFO-Framework bereitgestellt werden, implementiert. "Concert" definiert Schnittstellen für an bildgebenden Beamlines häufig verwendete Standardkomponenten, wie zum Beispiel Hochgeschwindigkeitskameras, Rotations- und Linearmotoren, Probenwechsler, Strahlmonochromatoren usw. Um ein gemeinsames Zugriffsschema für verschiedene Hochgeschwindigkeitskameras zu realisieren, wird die "Unified Camera Abstraction Library" (libuca) verwendet. libuca arbeitet mit lokalen und entfernten Kameras und ist in der Lage, Übertragungsraten bis zu 5000 Bildern pro Sekunde zu erreichen (bei einer 8-Bit 1-Megapixel-Kamera und FDR-Infiniband-Verbindungen). Zur Kommunikation mit Standardgeräten wird ein Tango-Wrapper verwendet. Für die Arbeit mit Aerotech- und Compact RIO-basierten Motoren und einer Vielzahl anderer Geräte werden dedizierte Komponenten bereitgestellt. "Concert" vereinfacht Standardoperationen wie die Ausrichtung der Rotationsachse, die Fokussierung der Kamera, das Auffinden und Zentrieren des Strahls erheblich. Schließlich lässt sich "Concert" auch in das Datenverwaltungssystem integrieren. Metadaten über die Prozessparameter werden automatisch von den Instrumenten abgerufen, können aber auch vom Benutzer erweitert werden und werden zusammen mit den Messdaten gespeichert.

Rekonstruktion in Echtzeit

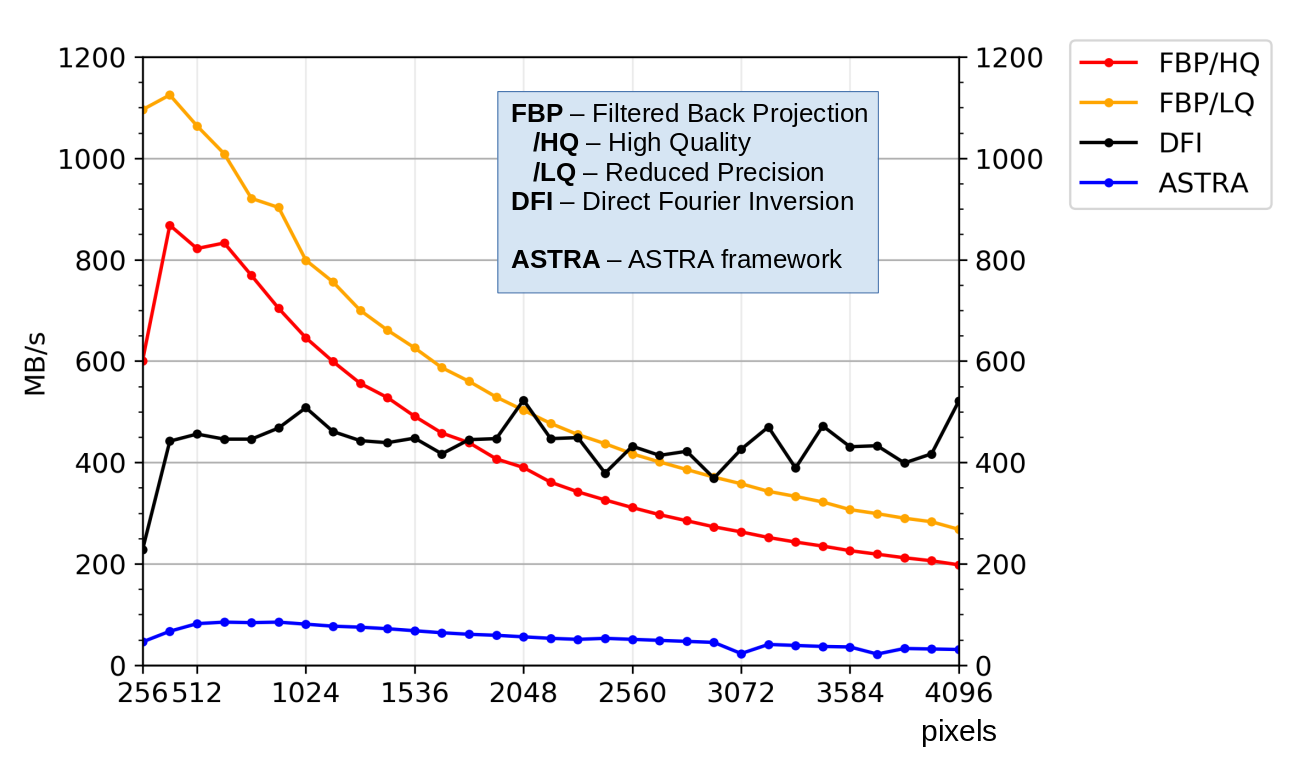

Für die tomographische Rekonstruktion in Echtzeit bietet das UFO-Framework zwei Methoden an: Gefilterte Rückprojektion (FBP) und Direkte Fourier Inversion (DFI). Verglichen mit dem meist verwendeten FBP-Algorithmus ist DFI empfindlicher gegenüber Rauschen, aber etwas schneller. Beide Algorithmen sind für die GPU-Architektur implementiert und optimiert. Darüber hinaus bieten wir Rekonstruktionsmodi mit reduzierter Genauigkeit. Die verringerte Bildqualität ist für Echtzeitanwendungen oft akzeptabel. Sie beschleunigt die Ausführung, während die erzeugten Ergebnisse immer noch ausreichend sind, um zuverlässige Entscheidungen im Experimentierbetrieb zu treffen. Wie in Abb. 6 dargestellt, übertrifft die UFO-Implementation der Rekonstruktionsalgorithmen die Performanz des populären ASTRA-Toolkits deutlich. Die optimierten Algorithmen erreichen einen Durchsatz von 1 GB/s auf einer einzelnen GPU und bis zu 8 GB/s auf einem GPU-Server. Diese Verarbeitungsgeschwindigkeit übertrifft die Datenraten der derzeit existierenden wissenschaftlichen Kameras deutlich. Neben der Echtzeit-Rekonstruktion können die entwickelten Algorithmen auch zur Beschleunigung der ansonsten langsamen Low-Dose-Rekonstruktion eingesetzt werden, die normalerweise offline durchgeführt wird. Weitere Einzelheiten zu den entwickelten Algorithmen sind veröffentlicht in

zu finden.

Projekte

- UFO - Synchrotron-Röntgentomographie

- ROOF - Dynamische Verfolgung von Strukturen in mehrphasigen Systemen

- ASTOR / NOVA - Synergetische Datenanalyse

Für Studierende

Wir bieten durchgehend Themen für studentische Arbeiten rund um die Computertomographie an. Wir erwarten von den Studenten Erfahrungen in der Bildverarbeitung und gute Python-Programmierkenntnisse. Einige Themen erfordern ein gutes Verständnis von GPU-Architekturen und Erfahrungen mit parallelen Programmiertechniken. Bitte kontaktieren Sie uns, wenn Sie Interesse an Hochleistungsrechnen und -tomographie haben. Die Palette möglicher Themen ist breit gefächert:

- Allgemeine Bildverarbeitung: Rauschunterdrückung, Artefaktkompensation, etc.

- Entwicklung von spezifischen Algorithmen für die tomographische Rekonstruktion

- Parallelisierung und Optimierung von Bildverarbeitungssoftware

- Bewegungserkennung („Optical Flow“), Bildsegmentierung und Visualisierung

Publikationen

Funkner, S.; Niehues, G.; Nasse, M. J.; Bründermann, E.; Caselle, M.; Kehrer, B.; Rota, L.; Schönfeldt, P.; Schuh, M.; Steffen, B.; Steinmann, J. L.; Weber, M.; Müller, A.-S.

2023. Scientific Reports, 13 (1), Art.-Nr.: 4618. doi:10.1038/s41598-023-31196-5

Faragó, T.; Gasilov, S.; Emslie, I.; Zuber, M.; Helfen, L.; Vogelgesang, M.; Baumbach, T.

2022. Journal of Synchrotron Radiation, 29 (3), 916–927. doi:10.1107/S160057752200282X

Ametova, E.; Burca, G.; Chilingaryan, S.; Fardell, G.; J rgensen, J. S.; Papoutsellis, E.; Pasca, E.; Warr, R.; Turner, M.; Lionheart, W. R. B.; Withers, P. J.

2021. Journal of Physics D: Applied Physics, 54 (32), Art.-Nr.: 325502. doi:10.1088/1361-6463/ac02f9

Funkner, S.; Niehues, G.; Nasse, M.; Bründermann, E.; Caselle, M.; Kehrer, B.; Rota, L.; Schönfeldt, P.; Schuh, M.; Steffen, B.; Steinmann, J.; Weber, M.; Müller, A.-S.

2020, September 24. 8th MT ARD ST3 Meeting 2020, Karlsruhe, Deutschland (2020), Online, 23.–24. September 2020

Raasch, J.; Thoma, P.; Scheuring, A.; Ilin, K.; Wünsch, S.; Siegel, M.; Smale, N.; Judin, V.; Hiller, N.; Müller, A.-S.; Semenov, A.; Hübers, H.-W.; Caselle, M.; Weber, M.; Hänisch, J.; Holzapfel, B.

2013, Februar 1. KSETA Inauguration Symposium (2013), Karlsruhe, Deutschland, 1. Februar 2013

Chilingaryan, S. A.

2020, Mai 12. Lunch and learn session at Photon Science Institute, University of Manchester (2020), Manchester, Vereinigtes Königreich, 12. Mai 2020

Funkner, S.; Niehues, G.; Nasse, M. J.; Bründermann, E.; Caselle, M.; Kehrer, B.; Rota, L.; Schönfeldt, P.; Schuh, M.; Steffen, B.; Steinmann, J. L.; Weber, M.; Müller, A.-S.

2019

Chilingaryan, S.; Ametova, E.; Kopmann, A.; Mirone, A.

2019. Journal of real-time image processing, 17 (5), 1331–1373. doi:10.1007/s11554-019-00883-w

Chilingaryan, S. A.

2019. YerPhI Seminar (2019), Jerewan, Armenien, 16. Mai 2019

Chilingaryan, S.; Ametova, E.; Kopmann, A.; Mirone, A.

2019. 2018 30th International Symposium on Computer Architecture and High Performance Computing: SBAC-PAD 2018 ; Lyon, France, 24-27 September 2018 ; Proceedings, 158–166, Institute of Electrical and Electronics Engineers (IEEE). doi:10.1109/CAHPC.2018.8645862

Asadchikov, V.; Buzmakov, A.; Chukhovskii, F.; Dyachkova, I.; Zolotov, D.; Danilewsky, A.; Baumbach, T.; Bode, S.; Haaga, S.; Hänschke, D.; Kabukcuoglu, M.; Balzer, M.; Caselle, M.; Suvorov, E.

2018. Journal of applied crystallography, 51 (6). doi:10.1107/S160057671801419X

Ametova, E.; Ferrucci, M.; Chilingaryan, S.; Dewulf, W.

2018. Precision engineering, 54, 233–242. doi:10.1016/j.precisioneng.2018.05.016

Haas, D.; Mexner, W.; Spangenberg, T.; Cecilia, A.; Vagovic, P.; Kopmann, A.; Balzer, M.; Vogelgesang, M.; Pasic, H.; Chilingaryan, S.

2012. 9th International Workshop on Personal Computers and Particle Accelerator Controls (PCaPAC 2012), Kolkata, IND, December 4-7, 2012, 103–105, JACoW Publishing

Kopmann, A.; Chilingaryan, S.; Vogelgesang, M.; Dritschler, T.; Shkarin, A.; Shkarin, R.; Santos Rolo, T. dos; Farago, T.; Kamp, T. Van de; Balzer, M.; Caselle, M.; Weber, M.

2016. 2016 IEEE Nuclear Science Symposium, Medical Imaging Conference and Room-Temperature Semiconductor Detector Workshop (NSS/MIC/RTSD), Strasbourg, France, 29 October–6 November 2016, 1–5, Institute of Electrical and Electronics Engineers (IEEE). doi:10.1109/NSSMIC.2016.8069895

Ametova, E.; Ferrucci, M.; Chilingaryan, S.; Dewulf, W.

2018. Measurement science and technology, 29 (6), Art. Nr.: 065007. doi:10.1088/1361-6501/aab1a1

Jerome, N. T.; Ateyev, Z.; Lebedev, V.; Hopp, T.; Zapf, M.; Chilingaryan, S.; Kopmann, A.

2017. Proceedings of the International Workshop on Medical Ultrasound Tomography: 1.- 3. Nov. 2017, Speyer, Germany. Hrsg.: T. Hopp, 349–359, KIT Scientific Publishing. doi:10.5445/IR/1000080283

Jerome, N. T.; Chilingaryan, S.; Shkarin, A.; Kopmann, A.; Zapf, M.; Lizin, A.; Bergmann, T.

2017. IVAPP 2017 : 8th International Conference on Information Visualization Theory and Applications, Porto, Portugal, 27. Februar - 1. März.2017. Vol.: 3. Ed.: L. Linsen (IVAPP is part of VISIGRAPP, the 12th International Joint Conference on Computer Vision, Imaging and Computer Graphics Theory and Applications), 152–163, SciTePress. doi:10.5220/0006228101520163

Schmelzle, S.; Heethoff, M.; Heuveline, V.; Lösel, P.; Becker, J.; Beckmann, F.; Schluenzen, F.; Hammel, J. U.; Kopmann, A.; Mexner, W.; Vogelgesang, M.; Jerome, N. T.; Betz, O.; Beutel, R.; Wipfler, B.; Blanke, A.; Harzsch, S.; Hörnig, M.; Baumbach, T.; Kamp, T. Van de

2017. Developments in X-Ray Tomography XI, San Diego, CA, August 6-10, 2017. Ed.: B. Müller, 103910P, Society of Photo-optical Instrumentation Engineers (SPIE). doi:10.1117/12.2275959

Farago, T.; Mikulik, P.; Ershov, A.; Vogelgesang, M.; Hänschke, D.; Baumbach, T.

2017. Journal of synchrotron radiation, 24 (6), 1283–1295. doi:10.1107/S1600577517012255

Ametova, E.; Ferrucci, M.; Chilingaryan, S.; McCarthy, M.; Dewulf, W.

2016. 31st Annual Meeting of the American Society for Precision Engineering (ASPE), Portland, OR, USA; 23 - 28 October 2016, 287–292, ASPE

Vogelgesang, M.; Rota, L.; Perez, L. E. A.; Caselle, M.; Chilingaryan, S.; Kopmann, A.

2016. Developments in X-Ray Tomography X, San Diego, United States, 29 - 31 August, 2016, Art. Nr.: 996715, Society of Photo-optical Instrumentation Engineers (SPIE). doi:10.1117/12.2237611

Kopmann, A.; Chilingaryan, S.; Vogelgesang, M.; Dritschler, T.; Shkarin, A.; Shkarin, R.; Santos Rolo, T. dos; Farago, T.; Kamp, T. van de; Balzer, M.; Caselle, M.; Weber, M.; Baumbach, T.

2016. IEEE Nuclear Science Symposium (NSS) and Medical Imaging Conference (MIC), Strasbourg, F, October 29 - November 5, 2016

Vogelgesang, M.; Rota, L.; Ardila Perez, L. E.; Caselle, M.; Chilingaryan, S.; Kopmann, A.

2016. Developments in X-Ray Tomography X, San Diego, CA, August 29-31, 2016. Ed.: S.R. Stock, 996715/1–9, Society of Photo-optical Instrumentation Engineers (SPIE)

Vogelgesang, M.; Rota, L.; Ardila Perez, L. E.; Caselle, M.; Chilingaryan, S.; Kopmann, A.

2016. Developments in X-Ray Tomography X, San Diego, CA, August 29-31, 2016

Vogelgesang, M.; Farago, T.; Morgeneyer, T. F.; Helfen, L.; Dos Santos Rolo, T.; Myagotin, A.; Baumbach, T.

2016. Journal of synchrotron radiation, 23, 1254–1263. doi:10.1107/S1600577516010195

Chilingaryan, S.

2016. Topical Workshop on Parallel Computing for Data Acquisition and Online Monitoring, Karlsruhe, February 7-8, 2016

Kamp, T. Van de; Santos Rolo, T. dos; Farago, T.; Kopmann, A.; Vogelgesang, M.; Chilingaryan, S.; Ershov, A.; Baumbach, T.

2015. 12th International Conference on Synchrotron Radiation Instrumentation (SRI 2015), New York, N.Y., July 6-10, 2015

Chilingaryan, S.; Ametova, E.; Buldygin, R.; Shkarin, A.; Vogelgesang, M.

2015. YerPhI CRD Seminar, Yerevan Physics Institute, Yerevan, ARM, May 19, 2015

Stevanovic, U.; Caselle, M.; Cecilia, A.; Chilingaryan, S.; Farago, T.; Gasilov, S.; Herth, A.; Kopmann, A.; Vogelgesang, M.; Balzer, M.; Baumbach, T.; Weber, M.

2015. IEEE transactions on nuclear science, 62, 911–918. doi:10.1109/TNS.2015.2425911

Shkarin, R.; Ametova, E.; Chilingaryan, S.; Dritschler, T.; Kopmann, A.; Mirone, A.; Shkarin, A.; Vogelgesang, M.; Tsapko, S.

2015. Fundamenta informaticae, 141 (2-3), 245–258. doi:10.3233/FI-2015-1274

Vogelgesang, M.

2014. Karlsruher Institut für Technologie (KIT). doi:10.5445/IR/1000048019

Vogelgesang, M.

2015. Vortr.: Helmholtz-Zentrum Dresden-Rossendorf, 11.Mai 2015

Vogelgesang, M.

2015. PNI-HDRI Spring Meeting, DESY, Hamburg, April 13-14, 2015

Vondrous, A.; Jejkal, T.; Dapp, R.; Stotzka, R.; Mexner, W.; Ressmann, D.; Mauch, V.; Kopmann, A.; Vogelgesang, M.; Farago, T.; Kamp, T. van de

2015. 3rd ASTOR Working Day, Karlsruhe, March 19, 2015

Khokhriakov, I.; Lottermoser, L.; Gehrke, R.; Kracht, T.; Wintersberger, E.; Kopmann, A.; Vogelgesang, M.; Beckmann, F.

2014. Optics and Photonics 2014, San Diego, Calif., August 17-21, 2014

Kopmann, A.; Balzer, M.; Caselle, M.; Chilingaryan, S.; Dritschler, T.; Farago, T.; Herth, A.; Rota, L.; Stevanovic, U.; Vogelgesang, M.; Weber, M.

2014. Science 3D Workshop, Hamburg June 2-4, 2014

Khokhriakov, I.; Lottermoser, L.; Gehrke, R.; Kracht, T.; Wintersberger, E.; Kopmann, A.; Vogelgesang, M.; Beckmann, F.

2014. Developments in X-Ray Tomography IX : Proceedings of Optics and Photonics 2014, San Diego, CA, August 18-20, 2014. Ed.: S. R. Stock, Article no 921217, Society of Photo-optical Instrumentation Engineers (SPIE). doi:10.1117/12.2060975

Lytaev, P.; Hipp, A.; Lottermoser, L.; Herzen, J.; Greving, I.; Khokhriakov, I.; Meyer-Loges, S.; Plewka, J.; Burmester, J.; Caselle, M.; Vogelgesang, M.; Chilingaryan, S.; Kopmann, A.; Balzer, M.; Schreyer, A.; Beckmann, F.

2014. Optics and Photonics 2014, San Diego, Calif., August 17-21, 2014

Lytaev, P.; Hipp, A.; Lottermoser, L.; Herzen, J.; Greving, I.; Khokhriakov, I.; Meyer-Loges, S.; Plewka, J.; Burmester, J.; Caselle, M.; Vogelgesang, M.; Chilingaryan, S.; Kopmann, A.; Balzer, M.; Schreyer, A.; Beckmann, F.

2014. Developments in X-Ray Tomography IX : Proceedings of Optics and Photonics 2014, San Diego, CA, August 18-20, 2014. Ed.: S. R. Stock, Article no 921218, Society of Photo-optical Instrumentation Engineers (SPIE). doi:10.1117/12.2061389

Vogelgesang, M.

2014. Workshop on Fast Data Processing on GPUs, Dresden, May 15, 2014

Vogelgesang, M.

2014. Science 3D Workshop, Hamburg June 2-4, 2014

Vogelgesang, M.

2014. PaNdata ODI Open Workshop (POOW’14), Amsterdam, NL, September 25, 2014

Chilingayan, S.; Balzer, M.; Caselle, M.; Santos Rolo, T. dos; Dritschler, T.; farago, T.; Kopmann, A.; Stevanovic, U.; Kamp, T. van de; vogelgesang, M.; Asadchikov, V.; Baumbach, T.; Myagotin, A.; Tsapko, S.; Weber, M.

2014. Deutsche Tagung für Forschung mit Synchrotronstrahlung, Neutronen und Ionenstrahlen an Großgeräten (SNI 2014), Bonn, 21.-23. September 2014

Vogelgesang, M.; Kopmann, A.; Farago, T.; Santos Rolo, T. dos; Baumbach, T.

2013. 14th International Conference on Accelerator and Large Experimental Physics Control Systems, San Francisco, Calif., October 6-11, 2013

Vogelgesang, M.; Kopmann, A.; Farago, T.; Santos Rolo, T. dos; Baumbach, T.

2013. 14th International Conference on Accelerator and Large Experimental Physics Control Systems, San Francisco, Calif., October 6-11, 2013 Proceedings Publ.Online Paper TUPPC044

Vogelgesang, M.

2014. KSETA Plenary Workshop, Bad Herrenalb, 24.-26.Februar 2014

Vogelgesang, M.

2013. HDRI/PanData Workshop, Hamburg, 4.-5.März 2013

Vogelgesang, M.; Farago, T.; Rolo, T.; Kopmann, A.; Mexner, W.; Baumbach, T.

2013. 27th Tango Collaboration Meeting, Barcelona, E, May 21-24, 2013

Chilingaryan, S.; Kopmann, A.; Myagotin, A.; Vogelgesang, M.

2011. Workshop on IT Research and Development at ANKA, Karlsruhe, July 19, 2011

Haas, D.; Mexner, W.; Spangenberg, T.; Cecilia, A.; Kopmann, A.; Balzer, M.; Vogelgesang, M.; Pasic, H.; Chilingaryan, S.

2012. 9th Internat.Workshop on Personal Computers and Particle Accelerator Controls (PCaPAC-2012), Kolkata, IND, December 4-7, 2012

Vogelgesang, M.; Chilingaryan, S.; Santos Rolo, T. dos; Kopmann, A.

2012. 14th Internat.Conf.on High Performance Computing and Communication (HPCC9) and 9th Internat.Conf.on Embedded Software and Systems (ICESS), Liverpool, GB, June 25-27, 2012

Vogelgesang, M.; Chilingaryan, S.; Santos Rolo, T. dos; Kopmann, A.

2012. 14th Internat.Conf.on High Performance Computing and Communication (HPCC9) and 9th Internat.Conf.on Embedded Software and Systems (ICESS), Liverpool, GB, June 25-27, 2012. Ed.: G. Min, 824–829, Institute of Electrical and Electronics Engineers (IEEE). doi:10.1109/HPCC.2012.116

Chilingaryan, S. A.; Caselle, M.; Kamp, T. van de; Kopmann, A.; Mirone, A.; Stevanovic, U.; Santos Rolo, T. dos; Vogelgesang, M.

2012. GPU Technology Conf.2012 (GTC), San Jose, Calif., May 14-17, 2012

Vogelgesang, M.; Chiligaryan, S.; Kopmann, A.

2011. Internat.Conf.for High Performance Computing, Networking, Storage and Analysis (SC’11), Seattle, Wash., November 12-18, 2011

Balzer, M.; Caselle, M.; Chilingaryian, S.; Herth, A.; Kopmann, A.; Stevanovic, U.; Vogelgesang, M.; Santos Rolo, T. dos

2012. Tagung der Studiengruppe für Elektronische Instrumentierung (SEI), Dresden-Rossendorf, 12.-14.März

Chilingaryan, S.; Vogelgesang, M.; Kopmann, A.

2011. Meeting of the High Data Rate Processing and Analysis Initiative (HDRI), Hamburg, May 16, 2011

Chilingaryan, S.

2011. Meeting on Tomographic Reconstruction Software, Grenoble, F, March 30 - April 1, 2011

Chilingaryan, S.

2009. Chen, L. [Hrsg.] Database Systems for Advanced Applications : DASFAA 2009 Internat.Workshops: BenchmarX, MCIS, WDPP, PPDA, MBC, PhD, Brisbane, AUS, April 20-23, 2009 Berlin [u.a.] : Springer, 2009 (Lecture Notes in Computer Science ; 5667)

Chilingaryan, S.

2009. Chen, L. [Hrsg.] Database Systems for Advanced Applications : DASFAA 2009 Internat.Workshops: BenchmarX, MCIS, WDPP, PPDA, MBC, PhD, Brisbane, AUS, April 20-23, 2009 Berlin [u.a.] : Springer, 2009 (Lecture Notes in Computer Science ; 5667), 21–34