In zahlreichen wissenschaftlichen Disziplinen fallen große multidimensionale Daten an. Deren effiziente Erfassung, Speicherung, Verarbeitung sowie deren Visualisierung sind Kernkompetenzen unseres Instituts. Wir entwickeln Methoden zur effizienten Verarbeitung wissenschaftlicher Daten, angefangen bei der Datenaufnahme in der Prozessdatenverarbeitung, über komplexe Workflows zur Datenanalyse bis zur Visualisierung und wissenschaftlichen Interpretation.

Im Zuge des Managements und der Verarbeitung beschäftigen wir uns mit der Entwicklung von Algorithmen zur Bildgebung, Signal- und Bildverarbeitung, Mustererkennung und Datenanalyse um bereits frühzeitig in der Prozesskette effizient Informationen aus großen Datenmengen zu extrahieren. Die Anwendungen erstrecken sich von physikalischen Großexperimenten bis hin zur Medizinischen Diagnostik und Therapie.

Unsere Technologien

-

GPU-Computing

- IT Infrastruktur für wissenschaftliche Experimente und Cloud-basierte Dienste

- Kollaborative Datenanalyse

- Slow Control, Datenmanagement und Automation

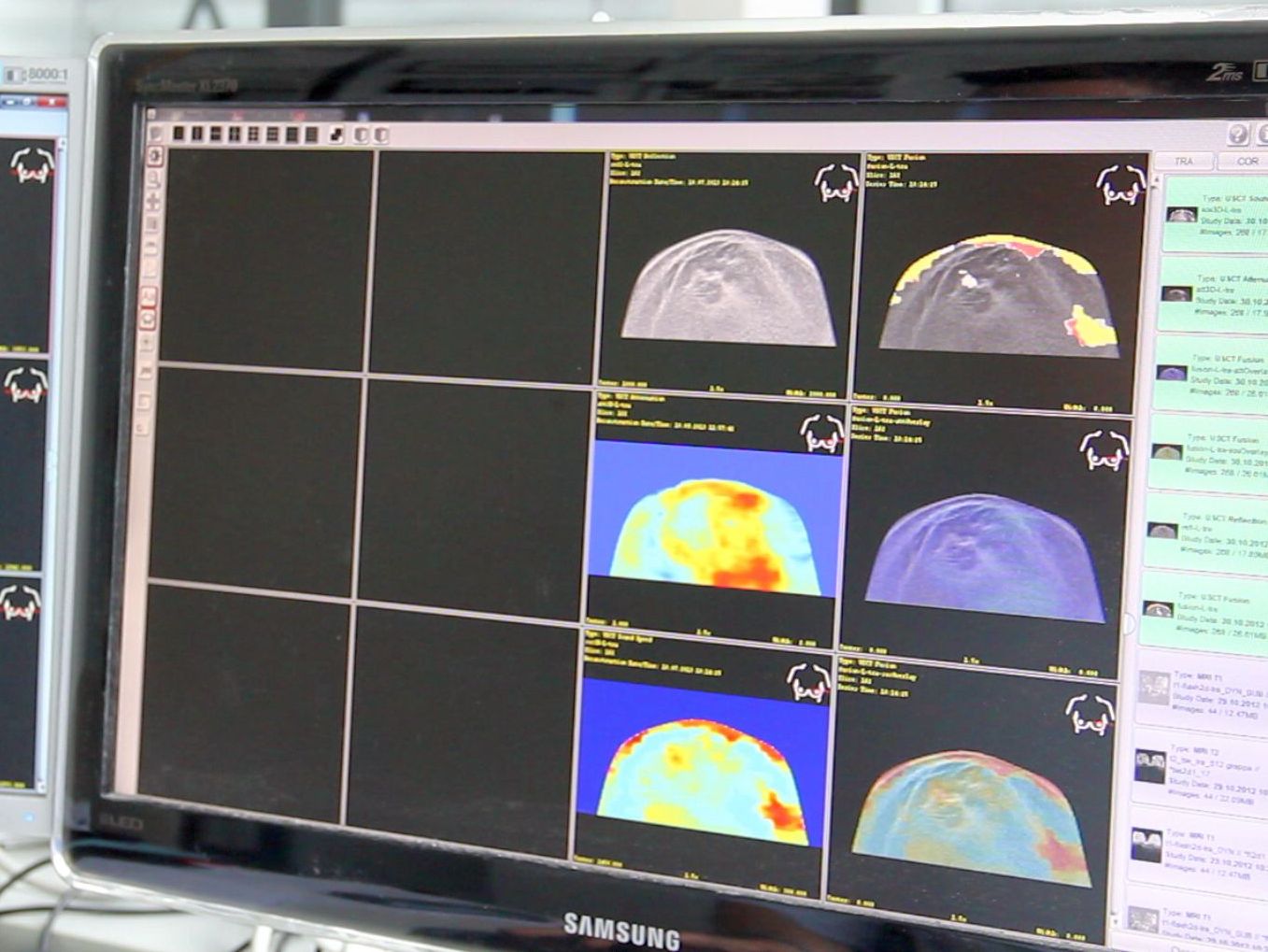

- Ultraschall-Computertomographie

- Ultraschall-Therapiesysteme

- Ultraschnelle Röntgenbildgebung

- HPC Cloud

- Datenackquisition mit hoher Bandbreite, Online Datenverarbeitung und Kontrolle mit niedriger Latenz

- Medizinische Bildverarbeitung